Az utóbbi években a nagy nyelvi modellek (LLM-ek), mint például az OpenAI által fejlesztett GPT sorozat, jelentős előrelépést hoztak a mesterséges intelligencia és a gépi tanulás terén. Ezek a modellek képesek emberi szintű szövegértésre, szöveggenerálásra, valamint egy sor egyéb nyelvi feladat elvégzésére. A legtöbb esetben azonban ezek a modellek felhőalapú szolgáltatásokként érhetők el, ami bizonyos körülmények között korlátozhatja azokat, akik a technológiát szeretnék felhasználni. E probléma megoldására egyre több kutató és fejlesztő fordul a helyileg futtatható nagy nyelvi modellek felé (local LLM). Ezek a modellek lehetővé teszik a felhasználók számára, hogy a saját hardverükön futtassák őket, ami számos előnyt rejt magában.

Az egyik legnagyobb előny, amit a helyileg futtatható LLM-ek kínálnak, az a fokozott adatvédelem és biztonság. Mivel az adatok nem hagyják el a felhasználó saját infrastruktúráját, ez csökkenti az adatszivárgás vagy -lopás kockázatát. Ez különösen fontos olyan érzékeny területeken, mint az egészségügy, a jog és a pénzügy, ahol az adatvédelem kritikus jelentőségű.

Ezek a „local LLM”-ek lehetővé teszik a felhasználók számára, hogy jobban testreszabják és optimalizálják a modelleket saját igényeikhez. Ez azt jelenti, hogy a vállalatok és kutatók kifejleszthetnek speciálisan az ő igényeikre szabott modelleket, amelyek hatékonyabban és pontosabban végzik el a kívánt feladatokat.

E modellek alkalmazása azonban nem mindenki számára ideális. Komoly hardverigényekkel rendelkeznek, ami magas költségekkel járhat. A nagy teljesítményű számítógépek, amelyek szükségesek a modellek futtatásához, nem minden szervezet vagy egyén számára elérhetők. Emellett a modellek telepítése, karbantartása és frissítése szakértelmet igényel, ami további erőforrásokat vonhat maga után.

Azoknak, akik a technikai hátterükkel és a megfelelő eszközökkel rendelkeznek, az otthon futtatható nagyméretű nyelvi modellek igazán hasznosak lehetnek. Ez a lehetőség főként nagy cégeknek, kutatási intézményeknek és innovatív startupoknak jelent előnyt, mivel ők állnak készen arra, hogy befektessenek az adatbiztonságba, a személyre szabás lehetőségeibe és a magas teljesítménybe.

De nézzük a másik oldalát is: még a hétköznapi emberek vagy a kis csapatok is belekóstolhatnak ebbe a technológiába, ha rendelkeznek az ehhez szükséges hardverrel, mint amilyen elég mennyiségű RAM és egy erős grafikus processzor. Azonban itt fontos tudni, hogy az ilyen modellek otthoni futtatásakor a teljesítmény nagyban függ a rendelkezésre álló hardvertől, és lehet, hogy kompromisszumokat kell kötni a sebesség vagy a pontosság terén, különösen a nagyobb modellek esetében.

Még ha az otthoni felhasználóknak szembe kell nézniük bizonyos technikai és adatvédelmi kihívásokkal is, az otthon futtatható nyelvi modellek még mindig remek lehetőséget kínálnak azoknak, akik ki szeretnék használni az mesterséges intelligencia által kínált előnyöket anélkül, hogy adataikat felhő alapú szolgáltatásokkal kellene megosztaniuk.

Ahogy a technológia fejlődik, és a hardver költségei csökkennek, várható, hogy egyre több szervezet és egyén fogja felismerni és kiaknázni ezeket a modelleket kínáló lehetőségeket.

Nézzük most, hogy milyen lehetőségek vannak, ha szeretnéd otthoni környezetben, a saját gépeden futtatni egy vagy több ilyen nagy nyelvi modellt. Az alábbi szoftverek ingyenesen letölthetőek bárki számára a netről.

Tartalomjegyzék

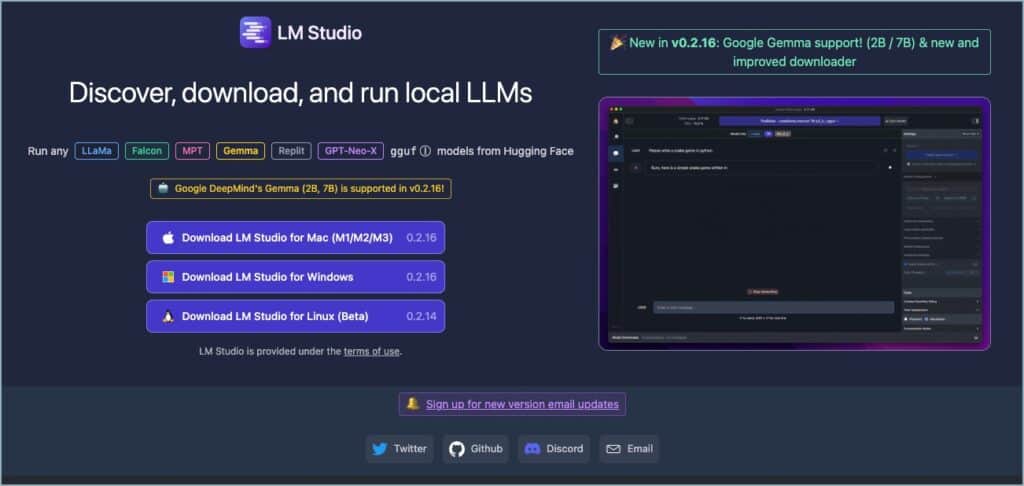

1 LM studio

hivatalos weboldal: LM Studio – Discover, download, and run local LLMs

Ismerd meg az LM Studio-t: Nyílt forráskódú nagy nyelvi modellek futtatása a saját gépeden

Ha érdekelnek a mesterséges intelligencia legújabb vívmányai, valószínűleg hallottál már a nagy nyelvi modellekről (LLM-ekről). Ezeket a komplex AI-modelleket hatalmas szöveges adatmennyiségen tréningezik, képesek emberi stílusú szövegek alkotására, kérdések megválaszolására, fordításra, és számos más feladatra.

Az LM Studio egy ingyenes nyílt forráskódú szoftver, ami lehetővé teszi, hogy ezeket a fejlett LLM-eket a saját gépeden futtasd. Segítségével a felhasználók könnyedén hozzáférhetnek a Hugging Face modelljeinek széles választékához, beleértve a LLama, Falcon, MPT, StarCoder, Replit, GPT-Neo-X modelleket és még sok mást.

Felhasználóbarát kialakításával és egyszerű felületével egyszerűvé teszi a kompatibilis modellfájlok letöltését és helyi futtatását. Az alkalmazás támogatja a Hugging Face-ről származó GGML, LLama, MPT, StarCoder modelleket is (LLama 2, Orca, Vicuna, Nous Hermes, WizardCoder, MPT stb.).

Az LM Studio egyik legfontosabb jellemzője, hogy lehetővé teszi az LLM-ek teljesen offline futtatását, így a felhasználók internetkapcsolat nélkül is dolgozhatnak projektjeiken. Ez ideálissá teszi azok számára, akik privát módon és biztonságosan szeretnék tartani adataikat.

A szoftver emellett alkalmazáson belüli chat felhasználói felületet is kínál, és kompatibilis az OpenAI-jal, így egyszerűen használható számos különböző modellel. Az alkalmazás adatokat gyűjt a tevékenységek megfigyeléséhez és annak biztosításához, hogy a modellek zökkenőmentesen fussanak, de minden adat helyben marad a felhasználó gépén, garantálva az adatvédelmet és a biztonságot.

Személyes használatra ingyenes, és letölthető Mac (M1/M2/M3), Windows és Linux (béta) rendszerekre. Az alkalmazáshoz minimum 16 GB RAM és 6 GB VRAM szükséges, Nvidia/AMD GPU-támogatással.

Az LM Studio főbb funkciói és előnyei

- LLM modellek egyszerű letöltése és futtatása: Böngéssz a támogatott modellek között, például a LLaMA, Falcon, GPT-Neo-X modellek.

- Chat felület: Interaktív módon beszélgethetsz a modellekkel, tesztelheted a képességeiket.

- OpenAI kompatibilis szerver: Összekapcsolhatod más, mesterséges intelligenciára épülő szoftverekkel.

- Offline működés: Nem kell internetkapcsolatra támaszkodnod, a modellek válaszait teljesen helyben generálja a géped.

- Adatvédelem: A feldolgozott szöveg, kérdéseid és a válaszok sosem hagyják el a saját gépedet, ezzel sokkal jobb adatvédelmet biztosít, mint a felhőalapú megoldások.

- Testreszabhatóság: Válogathatsz különböző LLM modellek közül a Hugging Face hatalmas tárházából, így megtalálhatod a céljaidnak legjobban megfelelőt.

Felhasználási területek

Az LM Studio sokrétű eszköz lehet írók, fejlesztők, kutatók, vagy akár kíváncsi hobbi felhasználók számára:

- Szövegalkotás: Ötletelés, történetek írása, cikkek vázlatának létrehozása.

- Fordítások: Szövegek fordítása más nyelvekre.

- Kódgenerálás: A modelleket rövid feladatleírások alapján akár programozási feladatok megoldására is ráveheted.

- Kutatás: A nagy nyelvi modellek működésének vizsgálata, saját modellek tréningezése.

LM Studio videó

Az LM Studio szoftverről van egy remek magyar nyelvű bemutató Pintér Zsolt Youtube csatornáján, érdemes megnézni (ahogy Zsolt több videóját is, iszonyatos tempóban készíti a profi videókat, mindenképpen iratkozz fel a csatornájára)

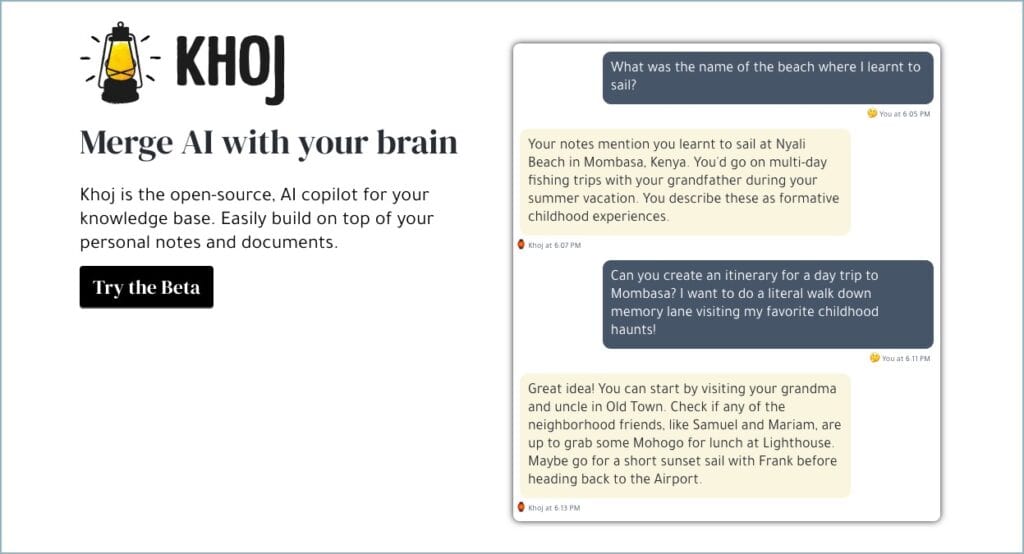

2 Khoj

hivatalos weboldal: https://khoj.dev/

Khoj: Nyílt forráskódú mesterséges intelligencia második agyként (second brain)

A folyamatosan bővülő digitális tudásbázisunk kezelése mindannyiunk számára kihívást jelent. A jegyzetek, dokumentumok és egyéb információk közötti hatékony keresés és értelmezés rengeteg időt emészt fel. A Khoj szoftver ebben nyújt segítséget – egy nyílt forráskódú mesterséges intelligencia alapú társ, amely segít második agyként rendszerezni a tudást.

Mit is kínál a Khoj?

- Tudás összekapcsolása: A Khoj képes megérteni a különféle formátumú szöveges tartalmakat: PDF-eket, egyszerű szöveges fájlokat, Markdown formátumú szövegeket, de még GitHub és Notion forrásokat is. A szoftver asztali alkalmazással is rendelkezik, így a fájlok szinkronban tarthatóak.

- A gondolkodás egyszerűsítése: Mesterséges intelligencia segítségével a Khoj rendszerezi a jegyzeteket és dokumentumokat. Az így létrejött kapcsolódási pontok megkönnyítik a tartalmak közötti navigációt és a lényeg kiemelését.

- Elérhetőség: A Khoj asztali alkalmazását minden népszerű operációs rendszeren használhatjuk. Ezen kívül az Emacs, Obsidian és WhatsApp felhasználóknak is van dedikált felület.

Könnyű beüzemelni

A Khoj egyik legnagyobb előnye, hogy a használatához nincs szükség bonyolult címkézési rendszerekre, tudásmenedzsment módszerekre. Elég az írás és olvasás, a Khoj a háttérben rendszerezi az adatokat a felhasználó igényeinek megfelelően.

Adatvédelem szem előtt tartásával

A Khoj teljesen nyílt forráskódú, így saját szerveren futtatva teljes kontroll alatt tarthatók az adatok. Lehetőség van offline üzemmód használatára, valamint az adatszivárgást megelőző „air-gapped” hálózati környezetben történő telepítésre is.

Kezdés és részletek

A Khoj helyi telepítéséhez és használatához mindössze néhány parancs szükséges (itt a teljes dokumentáció hozzá)

pip install khoj-assistant

khojA Khoj mögött álló csapat küldetése, hogy a személyes mesterséges intelligencia alapú asszisztensek elérhetőek, átláthatóak és biztonságosak legyenek a mindennapi használathoz.

3 Ollama

hivatalos weboldal: Ollama

Ollama: Code Llama futtatása egyszerűen a saját gépeden

A nagy nyelvi modellek (LLM-ek) egyre népszerűbbek, használhatók akár általános szöveggenerálásra vagy specifikus feladatokra, mint a programozás. Azonban nem könnyű telepíteni őket a saját gépedre. Az Ollama egy olyan eszköz, ami célja, hogy megkönnyítse az olyan modellek futtatását, mint a Code Llama.

Könnyű telepítés

Az Ollama egyik legnagyobb előnye a telepítésének egyszerűsége. A letöltés és telepítés mindössze néhány kattintást igényel. Habár az Ollama egy parancssori eszköz, használata csak egyetlen parancs megtanulását igényli: ollama run [modellnév]. Ha a modell még nem elérhető a gépeden, automatikusan letöltődik.

Modellek választéka

Az Ollama számos különböző Llama-alapú modellt támogat. Ezek között találhatóak a sima Llama 2, a programozásra optimalizált Code Llama, a programozási feladatokra fejlesztett CodeUp (DeepSE), és az orvosi kérdésekre specializált medllama2. A modellek teljes listája megtalálható az Ollama weboldalán: https://ollama.ai/library

Rendszerigények

Fontos figyelembe venni, hogy az Ollama mögötti modellek meglehetősen erőforrás-igényesek lehetnek. A készítők tanácsa: „Legalább 8 GB RAM a 3B, 16 GB RAM a 7B, és 32 GB RAM a 13B méretű modellek futtatásához ajánlott.”

A Code Llama használata

Egy 16 GB RAM-mal felszerelt Macen meglepően gyorsan futott a 7B-s Code Llama. Remekül képes kezelni például bash/zsh shell parancsokra és programozási nyelvekre (Python, JavaScript) vonatkozó kérdéseket.

A Code Llama Ollamavval történő futtatása meglehetősen egyszerű, még a legkisebb modell is jól teljesített R kódolási kérdések megválaszolásában. A nagyobb modellek használata természetesen még pontosabb eredményeket hozhat.

Extra funkcionalitás

Az Ollama további funkciókat is kínál: integrálja a LangChain könyvtárat, és képes futtatni a PrivateGPT szolgáltatással is. Ezek részleteiről a GitHub repo oktatóanyagok oldalán találhatsz további információt.

Ha Mac-felhasználó vagy, aki szívesen használná a Code Llama-t a saját gépén, az Ollama egy nagyszerű lehetőség. Egyszerűen telepíthető és használható, és megnyitja az ajtót ezekhez az izgalmas modellekhez, amik jelentősen javíthatják a programozási képességeidet. A Windowsos verzióra még várni kell, de hamarosan az is elérhetőnek ígérkezik.

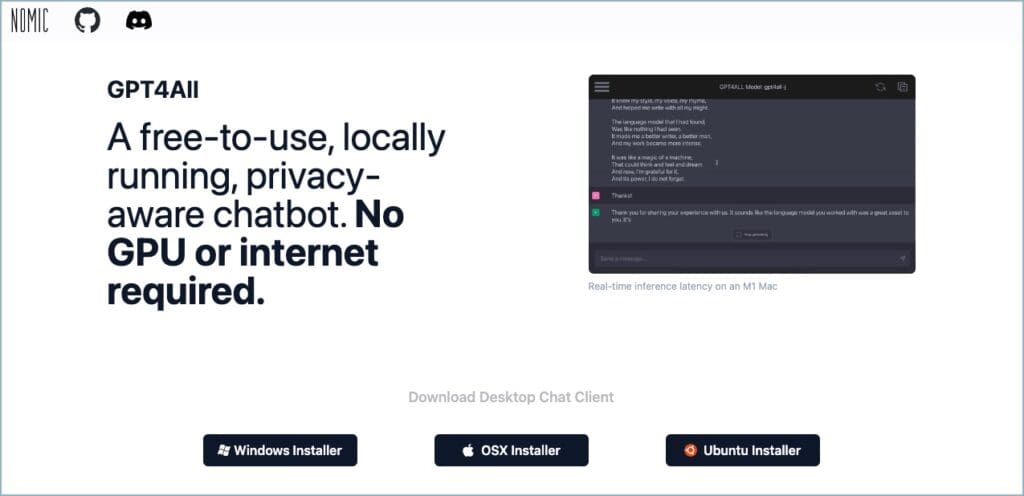

4 GPT4All

hivatalos weboldal: GPT4All

Ha egy olyan chatbotot keresel, ami teljes mértékben a gépeden fut, és nem küld adatokat máshova. Ingyenesen használható, a magánéletedre összpontosító chatbot, amit egyedülállóan helyi használatra terveztek. A szoftver olyan modellekkel működik, amik a saját rendszereden futnak, így te választhatod meg, hogy mely adatokkal dolgozik. Windows, macOS és Ubuntu rendszereken egyaránt elérhető.

Egyszerű beállítás

A GPT4All asztali alkalmazás első megnyitásakor mintegy 10 modellt tölthetsz le, amik helyben futtathatók lesznek. Köztük van a Meta AI Llama-2-7B chat modellje is. Ha rendelkezel API-kulccsal, az OpenAI GPT-3.5 és GPT-4 modelljeit is beállíthatod (bár ezek külső szerveren futnak majd).

Mit tud a GPT4All?

A GPT4All nem csak a kérdéseidre tud válaszolni, de még ennél is többet tud:

- Személyre szabott írási asszisztens: Legyen szó levélről, kreatív írásról, versek, sőt akár színdarabok írásáról is, a GPT4All segít.

- Dokumentumok megértése: Tölts be bármilyen szöveget vagy dokumentumot, és a GPT4All összefoglalókat és válaszokat fog adni a benne lévő kérdésekre.

- Könnyű kódolás: A GPT4All még a kódolásban is tud segíteni, de ez a funkció még fejlesztés alatt áll.

Tiszta és hatékony chat felület

Amint a modellek telepítésre kerülnek, a chatbot felület egyszerű és könnyen használható. A beszélgetést a vágólapra másolhatod, és válaszokat is generálhatsz a kényelmesebb folyamatért.

Chatelj a saját dokumentumoddal

A béta fázisban lévő LocalDocs plugin lehetővé teszi, hogy „beszélgess” a saját dokumentumaiddal, szintén helyileg. Ezt a beállításokban engedélyezheted, majd meg kell adnod egy adott mappát az indexeléshez. Fontos megjegyezni, hogy ez a funkció még fejlesztés alatt áll, előfordulhatnak pontatlanságok a válaszokban.

A GPT4All ökoszisztéma

A GPT4All nem csupán egy chat program, hanem egy egész ökoszisztéma:

- GPT4All Training: Saját GPT4All modellek betanítását teszi lehetővé.

- GPT4All Documentation: Részletes dokumentáció az LLM-ek helyi integrálásához.

- GPT4All Chat: Többplatformos chat felület a helyben futó LLM-ek használatához.

- GPT4All in Python: Python keretrendszer a GPT4All-hoz.

- GPT4All Datalake: Nyílt forráskódú adatbázis, melybe bárki hozzájárulhat interakciós adatokkal a jövőbeli GPT4All modellek fejlesztéséhez.

Teljesítmény

A GPT4All modellek már most is kiemelkedő teljesítményt nyújtanak a különböző benchmarkokon. Ahogy a szoftver tovább fejlődik, ezek az eredmények csak javulni fognak.

Hogyan működik a GPT4All?

A GPT4All célja, hogy a legjobb instrukciókövető asszisztens-típusú nyelvi modell legyen, amit bárki szabadon használhat, terjeszthet és fejleszthet. A modelljei 3-8 GB méretű fájlok, amelyeket letöltés után a GPT4All ökoszisztéma nyílt forráskódú szoftvereivel együtt használhatsz. A Nomic AI támogatja ezt a szoftver ökoszisztémát, és azon dolgozik, hogy még több ember számára legyen könnyen elérhető saját nagyméretű nyelvi modellek betanítása és telepítése.

Telepítés és használat

A GPT4All telepíthető Windowsra, MacOS-re és Ubuntu-ra is. A telepítőfájlokat letöltve és elindítva a programot könnyen megtalálod a kiválasztott mappában. A telepítés után pedig egy asztali ikont is kapsz.

Fontos: A Windows telepítője biztonsági figyelmeztetést adhat, de ez hamarosan megoldódik, amint a hivatalos tanúsítványok elérhetővé válnak.

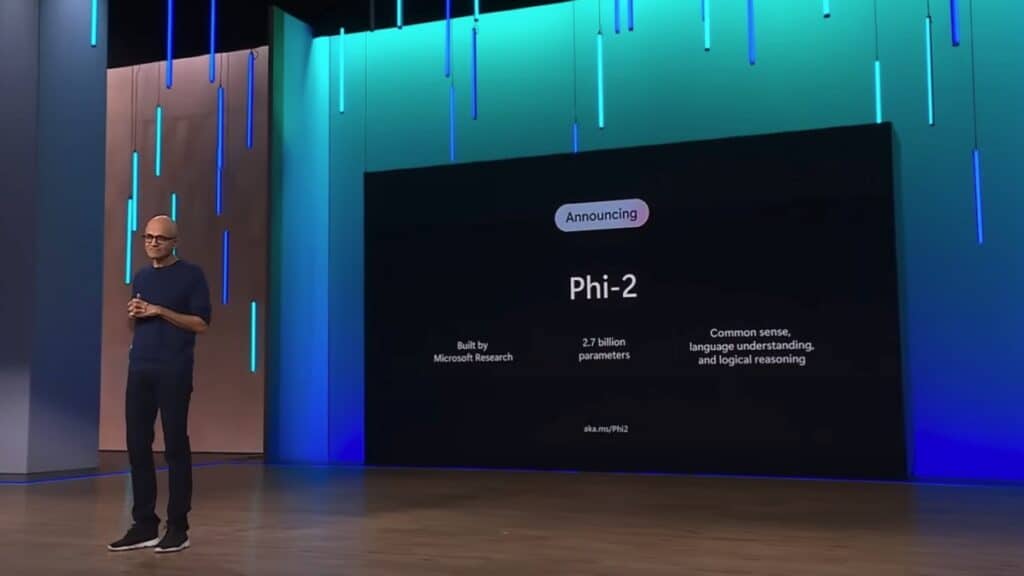

5 Phi-2

hivatalos weboldal: microsoft/phi-2 · Hugging Face

A világ egyre inkább az olyan nagyszabású nyelvi modellek felé fordul, mint a ChatGPT és más hasonlóak. Ezek a modellek figyelemre méltó eredményeket mutatnak, de számítási és tárolási szempontból is erőforrásigényesek lehetnek. Ezért egyre nagyobb az érdeklődés a kisebb, de ugyanolyan hatékony nyelvi modellek iránt. A Microsoft Phi-2 modellje az egyik ilyen figyelemre méltó példa.

Mi az a Phi-2?

A Phi-2 egy 2,7 milliárd paraméterrel rendelkező kis méretű nyelvi modell (SLM). Ugyanazon az adathalmazon képezték ki, mint a Phi-1.5-öt, de kiegészítettek egy újabb adatforrással, amely különféle mesterséges intelligencia által generált szövegekből és biztonsági okokból megszűrt weboldalakból áll. Amikor olyan tesztekkel értékelték, amelyek a józan észt, a nyelv megértését és a logikai gondolkodást mérték, a Phi-2 közel csúcskategóriás teljesítményt mutatott a 13 milliárd paraméternél kisebb modellek között.

Mire használható?

- Kérdés-felelet formátum: Megadhatod a kérdést, és a modell megpróbál közvetlen, lényegre törő választ adni.

- Csevegés: A Phi-2 képes emberi beszélgetést imitálni.

- Kódgenerálás: Bár elsősorban Python-ra optimalizálták, a modell alapvető kódokat is képes létrehozni.

Előnyei

Ezt a modellt nem finomhangolták emberi visszajelzések felhasználásával. Azért hozták létre nyílt forráskódúként, hogy a kutatói közösség rendelkezésére álljon egy kis méretű modell, amivel fontos biztonsági kihívásokat vizsgálhatnak, mint például a káros megnyilvánulások csökkentése, a társadalmi előítéletek megértése, az irányíthatóság javítása stb.

- Költséghatékony: A kisebb modellméret a Phi-2-t költséghatékonyabbá teszi a nagyszabású nyelvi modellekhez képest. Ez különösen előnyös olyan alkalmazások esetében, ahol a számítási erőforrások korlátozottak.

- Adatvédelem: A Phi-2 helyileg is futtatható, offline környezetben is. Ez lehetővé teszi a felhasználók számára, hogy jobban ellenőrizhessék adataikat, és biztosítsák azok biztonságát.

- Alkalmazkodóképesség: A Phi-2-t számos feladatra fel lehet használni, beleértve a szöveggenerálást, a besorolást és az érzelemanalízist. Ez sokféle alkalmazásban való felhasználásra alkalmassá teszi.

A Phi-2 hogyan használható?

- Notebookon keresztül: A Phi-2 futtatható egy olyan notebook segítségével, mint a Jupyter Notebook. Ez kényelmes módja a modellel való kísérletezésnek és a képességeinek felfedezésének.

- Alkalmazáson belül: A Phi-2 beágyazható alkalmazásokba, hogy nyelvi feldolgozási képességeket adjon azokhoz. Például használható egy olyan chatbot létrehozására, amely emberi beszélgetést utánzó módon tud válaszolni a felhasználói kérésekre.

Fontos megjegyezni

- A Phi-2 nem tökéletes. Téves tényeket vagy kódokat adhat ki. A modellt inkább ötletek forrásaként, ne kész megoldásokként kezeld.

- Sajnos előfordulhat, hogy társadalmi előítéleteket tükröz, vagy káros tartalmat generál, különösen, ha erre utasítjuk.

A Microsoft Phi-2-je a kis méretű nyelvi modellek ígéretes példája, amely számos gyakorlati alkalmazási területtel rendelkezik. Kisebb méretének és helyi futtatási képességének köszönhetően költséghatékony és adatvédelmi szempontból biztonságos alternatívája a nagyszabású nyelvi modelleknek. Ahogy a technológia fejlődik, valószínűleg még több hasonló SLM-et fogunk látni a piacon.

További információk

- Phi-2 modellkártya a HuggingFace weboldalon: https://huggingface.co/microsoft/phi-2

- LM Studio: https://lmstudio.ai/

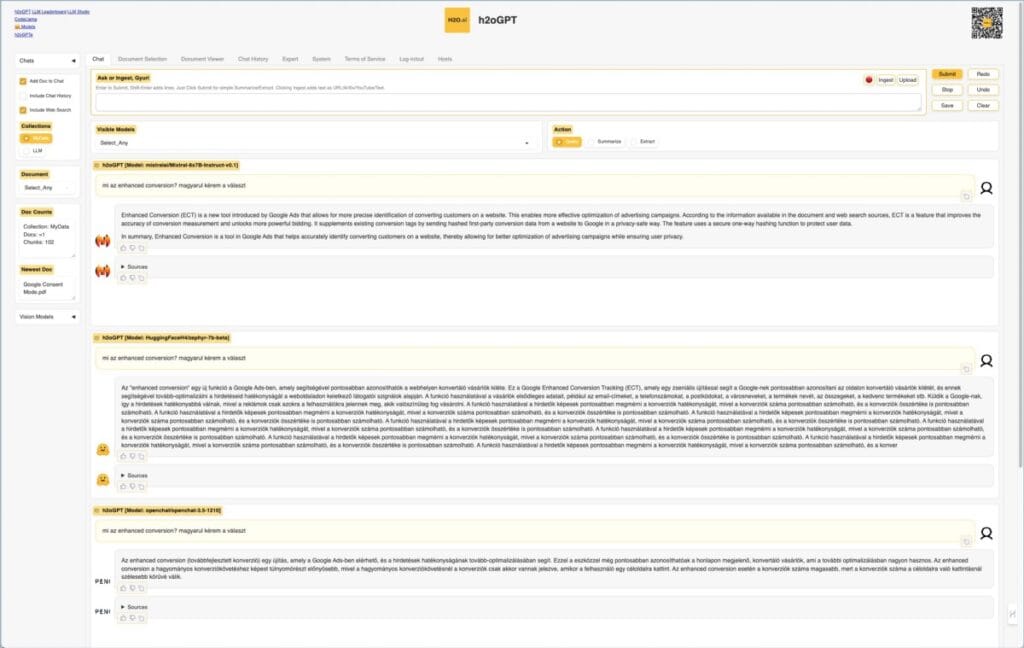

6 h2oGPT

hivatalos weboldal: gpt.h2o.ai

Ismerd meg a h2oGPT-t: Beszélgess a saját dokumentumaiddal

Szereted a ChatGPT-hez hasonló mesterséges intelligencia alapú chatbotokat, de szívesebben használnál egy olyat, ami a saját adataiddal tud dolgozni? Akkor imádni fogod a h2oGPT-t! A H2O.ai-től származó új szoftver lehetővé teszi, hogy kérdéseket tegyél fel a céges dokumentumaidról, projektjeidről, akár még a saját jegyzeteidről is.

Hogyan működik?

A h2oGPT egy nagy nyelvi modellen (LLM) alapul. Ez röviden azt jelenti, hogy az MI-t egy hatalmas adathalmazzal edzették, és így egy emberihez hasonló módon tudja feldolgozni és megérteni a szöveget. A h2oGPT különlegessége, hogy betöltheted a saját fájljaidat – szöveges anyagokat, PDF-eket, munkafüzeteket – és ezeket felhasználva tud válaszolni a kérdéseidre.

Kezdő lépések

Ha ki szeretnéd próbálni, akkor elsőként látogass el a gpt.h2o.ai oldalra. Itt egy demó verziót találsz, amit a saját géped használata nélkül érhetsz el, így könnyen kipróbálhatod, hogy szimpatikus-e a kezelőfelület. Vagy egyből mehetsz a codellama.h2o.ai oldalra is, ahol a 32k Codellama 34b Instruct modellt használhatod. Ez elég ügyes a tapasztalataim alapján.

Másik lehetőség a h2oGPT tesztverziójának letöltése. Az applikációt Windows és Mac gépeken egyaránt használhatod. Fontos, hogy a Windows-os változatot a vírusirtód jelezheti, de mivel nyílt forráskódú projektről van szó, viszonylag biztonságosnak mondható a használata.

Extra tudnivalók

- A h2oGPT felületén található egy „Expert” fül, ahol a hozzáértőbbek különböző paramétereket állítgatva finomíthatják a válaszok pontosságát.

- Ha videós segítségre van szükséged, Rob Mulla YouTube csatornáján hasznos információkat találsz a Linuxos telepítésről.

Bár a h2oGPT egyelőre kísérleti fázisban van, nagyon ígéretes technológiának tűnik. Képzeld csak el, milyen sokat segíthet majd a mindennapi munkádban, ha a kérdéseidet nem az interneten kell majd keresgélned, hanem azonnal megkaphatod a fontos információkat saját dokumentumaidból!

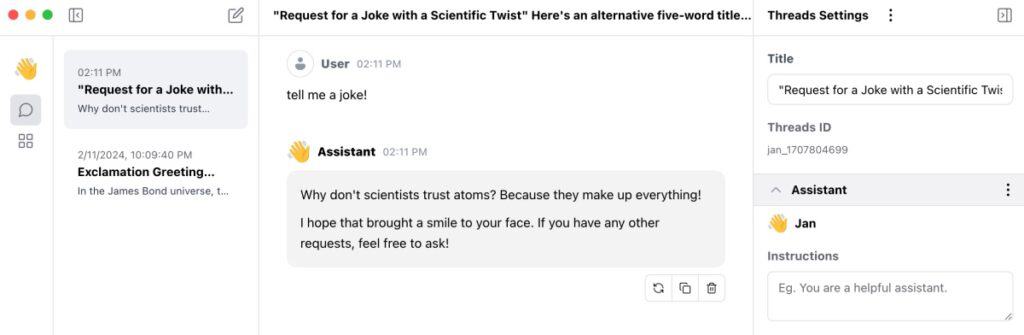

7 Jan.ai

hivatalos weboldal: Open-source ChatGPT Alternative | Jan

Nyílt forráskódú platform, amely teljes mértékben offline működik, és lehetővé teszi a helyi nyelvi modellek futtatását a számítógépen. A Jan.ai nem támaszkodik külső szerverekre vagy felhőszolgáltatásokra, hanem teljes mértékben a számítógépen fut. Ez azt jelenti, hogy a képes megőrizni a felhasználók adatait és preferenciáit, miközben biztosítja az adatok és beállítások magánjellegét és biztonságát.

Támogatja az univerzális architektúrákat, beleértve az Nvidia GPU-kat, az Apple M-sorozatot, az Apple Intel-t, a Linux Debian-t és a Windows x64-et. Ez azt jelenti, hogy szinte bármilyen hardveren képes futni, legyen az PC, laptop, vagy akár több GPU-s kluster.

Előnyei

A Jan.ai legnagyobb előnye, hogy teljes mértékben offline működik. Ez azt jelenti, hogy képes megőrizni a felhasználók adatait és preferenciáit, miközben biztosítja az adatok és beállítások magánjellegét és biztonságát.

Mivel nyílt forráskódú, a felhasználók szabadon módosíthatják és testreszabhatják a szolgáltatást saját igényeiknek megfelelően. Ez azt jelenti, hogy nem csak egy személyi asszisztens, hanem egy teljesen testreszabható AI platform, amely lehetővé teszi a fejlesztők számára, hogy saját AI modelleiket implementálják és futtassák.

8 Nvidia RTX Chat

hivatalos weboldal: Build a Custom LLM with Chat With RTX | NVIDIA

Gondolkoztál már azon, milyen hasznos lenne, ha egy mesterséges intelligencia bármilyen kérdést megválaszolna neked a saját dokumentumaid alapján? Az Nvidia Chat with RTX alkalmazása pontosan ezt tudja! Ez a demó program kifejezetten arra lett tervezve, hogy egy teljes mappányi dokumentum tartalmával kapcsolatos kérdésekre adjon válaszokat.

Hogyan is működik?

A Chat with RTX jelenleg kétféle nyelvi modellel használható (Mistral és Llama 2), melyeket helyben képes futtatni. Használatához szükséged lesz egy Windows számítógépre, erősebb Nvidia grafikus kártyával (GeForce RTX 30-as sorozat vagy újabb minimum 8GB videó RAM-mal). Az sem árt, ha van egy jó internetkapcsolatod, mert a letöltés mérete elég masszív, nagyjából 35GB tömörítve.

Kibontás után a Chat with RTX-nek egy egészen egyszerű, felhasználóbarát felülete van. Az ikonra kattintva megnyílik a géped parancssora, ahonnan a program betölti magát az alapértelmezett böngésződben.

Lássuk a lépéseket

- Válaszd ki, hogy melyik nyelvi modellt szeretnéd használni, és add meg a mappád elérési útvonalát.

- Várj, amíg a program elemzi a dokumentumokat (ezt a folyamatot a parancssor ablakban nyomon tudod követni).

- Ezután már fel is teheted a kérdésed!

A válasz nemcsak szöveget fog tartalmazni, de linkeket is azokhoz a dokumentumokhoz, amiket a mesterséges intelligencia felhasznált a válasz összeállításakor. Ez nagyon hasznos, ha szeretnéd ellenőrizni, hogy az információ tényleg helyes-e. Az alkalmazás jelenleg .txt, .pdf, .doc formátumú fájlokkal működik, de akár YouTube videókat is meg tudsz adni neki URL-linkként.

Fontos megjegyzés, hogy ez a program almappákat nem vizsgál, szóval minden fájlt, amit látni szeretnél benne, egy helyre kell pakolnod. Ha bővíted a mappa tartalmát, ne felejts el a „refresh” gombra kattintani az adatkészlet mellett, hogy a változásokat a program is észlelje.

Kinek ajánlom?

Ez a szoftver kifejezetten hasznos lehet neked, ha:

- Gyakran dolgozol nagy mennyiségű szöveggel

- Fontos, hogy a saját dokumentumaid alapján kapj válaszokat

- Nem szeretnéd, hogy az adataid egy külső szerverre kerüljenek

9 Milyen MAC-t vegyek nagyméretű nyelvi modellek (LLM) futtatásához?

Otthoni futtatáshoz nem a Mac a legideálisabb választás, de csak emiatt valószínűleg nem fogsz áttérni Windows-ra vagy Linux-ra, hogy például egy jó erős 4096-os Nvidia kártyát pakolhass a gépbe. Szóval nézzük, hogy ha Apple gépet vennél, akkor mik a lehetőségeid.

Local AI futtatása esetén az ajánlott MAC gépek és paraméterek:

| Model Mérete (Paraméterek száma) | Ajánlott Mac Modell | GPU Magok Száma | Memória (RAM) | Ajánlott Tárhely (GB) |

|---|---|---|---|---|

| 7B | Mac Mini / MacBook Air M2 | 8 | 16 GB | 256 |

| 13B | MacBook Pro M1 Pro | 16 | 16 GB | 512 |

| 33B – 46B (Mixtral 8x7B) | 16” M2 Pro MacBook Pro M1 Max | 24 | 64 GB | 1TB |

| 70B+ | Mac Studio M1 Ultra / M2 Ultra | 48 / 76 | 64 GB / 192 GB | 2TB+ |

| Javasolt min. konfigok a local futtatáshoz |

| Modell neve | CPU (mag) | GPU (mag) | Neural Engine (mag) | Memória GB (RAM) | Tárhely | Ár (Ft) |

|---|---|---|---|---|---|---|

| Mac mini M2 | 8 | 10 | 16 | 8 | 256 | 299990 |

| Mac mini M2 | 8 | 10 | 16 | 8 | 512 | 349990 |

| Mac mini M2 (CTO) | 8 | 10 | 16 | 16 | 512 | 449990 |

| Mac mini M2 (CTO) | 8 | 10 | 16 | 24 | 512 | 599990 |

| Mac mini M2 (CTO) | 8 | 10 | 16 | 24 | 1000 | 699990 |

| 14-inch MacBook Pro: Apple M3 chip | 8 | 10 | 16 | 8 | 512 | 799990 |

| 14-inch MacBook Pro: Apple M3 | 8 | 10 | 16 | 8 | 1000 | 899990 |

| 14-inch MacBook Pro: Apple M3 Pro | 11 | 14 | 16 | 18 | 512 | 999990 |

| Mac mini M2 Pro | 10 | 16 | 16 | 16 | 512 | 649990 |

| 14-inch MacBook Pro: Apple M3 Pro | 12 | 18 | 16 | 18 | 1000 | 1199990 |

| 16-inch MacBook Pro: Apple M3 Pro | 12 | 18 | 16 | 18 | 512 | 1249990 |

| 16-inch MacBook Pro: Apple M3 Pro | 12 | 18 | 16 | 36 | 512 | 1449990 |

| 16-inch MacBook Pro: Apple M3 Pro (CTO) | 12 | 18 | 16 | 36 | 1000 | 1549990 |

| Mac mini M2 Pro (CTO) | 12 | 19 | 16 | 16 | 512 | 799990 |

| Mac mini M2 Pro (CTO) | 12 | 19 | 16 | 32 | 512 | 999990 |

| Mac mini M2 Pro (CTO) | 12 | 19 | 16 | 32 | 1000 | 1099990 |

| APPLE 16-inch MacBook Pro | 12 | 19 | 16 | 16 | 512 | 1077777 |

| Mac Studio M2 Max | 12 | 30 | 16 | 32 | 512 | 979990 |

| Mac Studio M2 Max (CTO) | 12 | 30 | 16 | 32 | 512 | 979990 |

| 14-inch MacBook Pro: Apple M3 Max | 14 | 30 | 16 | 36 | 1000 | 1599990 |

| 16-inch MacBook Pro: Apple M3 Max | 14 | 30 | 16 | 36 | 1000 | 1749990 |

| 16-inch MacBook Pro: Apple M3 Max (CTO) | 14 | 30 | 16 | 96 | 1000 | 2149990 |

| Mac Studio M2 Max (CTO) | 12 | 38 | 16 | 32 | 512 | 1079990 |

| 14-inch MacBook Pro: Apple M3 Max | 16 | 40 | 16 | 48 | 1000 | 1849990 |

| 16-inch MacBook Pro: Apple M3 Max | 16 | 40 | 16 | 48 | 1000 | 1999990 |

| 16-inch MacBook Pro: Apple M3 Max (CTO) | 16 | 40 | 16 | 64 | 1000 | 2099990 |

| 16-inch MacBook Pro: Apple M3 Max (CTO) | 16 | 40 | 16 | 128 | 1000 | 2499990 |

| Mac Studio M1 Ultra | 20 | 64 | 32 | 128 | 1000 | 1471290 |

| Mac Studio M2 Ultra (CTO) | 24 | 60 | 32 | 32 | 512 | 1679990 |

| Mac Studio M2 Ultra | 24 | 60 | 32 | 64 | 1000 | 1979990 |

| Mac Studio M2 Ultra (CTO) | 24 | 76 | 32 | 32 | 512 | 2179990 |

| Mac Studio M2 Ultra (CTO) | 24 | 60 | 32 | 128 | 1000 | 2379990 |

| Mac Studio M2 Ultra (CTO) | 24 | 76 | 32 | 64 | 1000 | 2479990 |

| Mac Studio M2 Ultra (CTO) | 24 | 76 | 32 | 128 | 1000 | 2879990 |

| Mac Studio M2 Ultra (CTO) | 24 | 76 | 32 | 128 | 2000 | 3079990 |

| Mac Studio M2 Ultra (CTO) | 24 | 76 | 32 | 192 | 1000 | 3279990 |

| Mac Studio M2 Ultra (CTO) | 24 | 76 | 32 | 192 | 2000 | 3479990 |

Forrás:

Milyen MAC-t vegyek nagyméretű nyelvi modellek (LLM) futtatásához? – GYIK.com

Csatolmány (megjegyzés: 2024.03 árakról van szó)